Comment apprend l’IA ? Plongée au cœur des réseaux de neurones

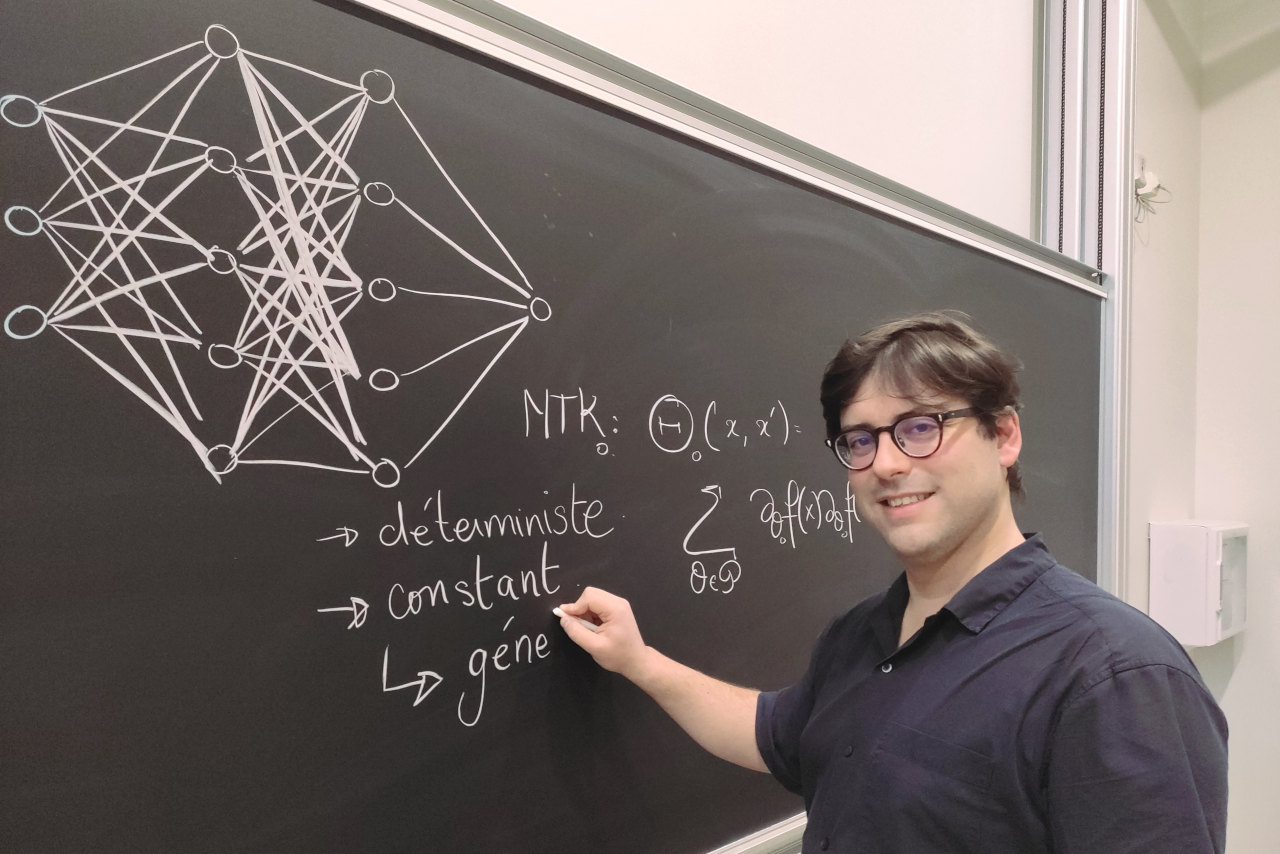

Au Laboratoire de sciences actuarielles et financières, Franck Gabriel mène des recherches en mathématiques appliquées, notamment, aux réseaux de neurones. Ses travaux ont permis une avancée majeure dans les processus d’apprentissage des réseaux de neurones. Plongée au cœur de l’IA avec ce chercheur lauréat de l'appel à projet Accueil, qui s’intéresse aussi bien à son essence qu’à ses usages sociétaux.

Créer une image, générer du texte, analyser des données médicales, optimiser une chaîne de production. Grâce à l'apprentissage profond (deep learning en anglais), l'IA est devenue extrêmement performante dans tous les domaines. Mais comment une machine apprend-elle à réaliser ces tâches ? Paradoxalement, pour les mathématiciens, ingénieurs, informaticiens qui codent ces machines, la question était jusqu'à très récemment loin d'être tranchée.

Les réseaux de neurones, de très bons élèves

Depuis la conception des réseaux de neurones, l’IA a fait des progrès fulgurants. L’intervention humaine au cours du processus d’apprentissage est de moins en moins nécessaire. Au centre de ces prouesses : les réseaux de neurones, qui sont en quelque sorte de (très) bons élèves. Pendant leur phase « d'entraînement », ils apprennent à résoudre des exercices selon les méthodes qu'on leur indique, ce qui leur permet ensuite d'être performants sur de nouveaux exercices inconnus.

Cette phase d’entraînement peut s’avérer très longue tant elle nécessite des calculateurs surpuissants et des corpus de données gigantesques. Ainsi, l’entraînement de GPT5, qui a démarré il y a quelques mois, est toujours en cours.

« Un réseau de neurone n’est ni plus ni moins qu'une fonction mathématique, avec un très grand nombre de paramètres », résume Franck Gabriel, chercheur au Laboratoire de Sciences Actuarielle et Financière (SAF).

À la manière d'un professeur, il s'agit donc d’avoir la méthode d'apprentissage la plus adaptée à l'élève (l'IA), en fonction du problème à résoudre. En langage mathématique, cela revient à trouver les paramètres adéquats pour la tâche donnée. Et pour cela, « il est essentiel de comprendre quel est le processus d'apprentissage de l'élève », détaille cet enseignant-chercheur en charge des enseignements de Deep learning à l’ISFA.

Après les mathématiques physiques et l’économie, ce chercheur s’intéresse aux réseaux de neurones et plus récemment à la blockchain. En 2023, il fait partie des lauréats de l’appel à projets interne Accueil de l’UCBL.

De nouveaux outils pour sonder le « cerveau » de l’IA

À quoi ressemble la fonction adéquate pour une architecture de réseau de neurones donnée ? Comment l'IA « réfléchit-elle » ? Comment considère-t-elle les données qu'on lui donne ? Les travaux de Franck Gabriel et de ses co-auteurs (Arthur Jacot et Clément Hongler) ont apporté des réponses à ces questions, et permis une avancée majeure dans la compréhension de l'apprentissage de l'IA. Notamment grâce à leur découverte du noyau tangent neuronal (NTK).

Cet objet mathématique permet une plongée dans le « cerveau » du réseau de neurones, son noyau. Chaque réseau de neurones en possède un qui lui est propre, qui est sa représentation du monde : comment il considère les données d’entrée, les associe, ou les différencie. Par exemple, à quel point l’IA va considérer comme proche l’image d’un chihuahua et d’un border collie ?

En particulier, à partir des données d'entrée et de ce noyau, le « modèle NTK » permet de prédire comment, dans certaines conditions, l'IA va apprendre et de quelle manière elle va résoudre de nouveaux problèmes similaires.

Une découverte de taille, mais qui a mis du temps à s'imposer. « Au départ, ça a été beaucoup d’efforts de communication en conférence pour faire accepter notre découverte », se rappelle Franck Gabriel. Venu du domaine des probabilités et des mathématiques physiques, ce jeune chercheur et ses co-auteurs étaient encore inconnus de la communauté des réseaux de neurones. À l'exception d'un des géants du secteur : Google, qui a rapidement manifesté son intérêt pour le NTK suite à la première publication de leurs résultats.

Une IA de plus en plus performante, vers quels usages ?

Aujourd'hui, le NTK est largement accepté comme outil pour étudier l'apprentissage des réseaux de neurones. Google a développé une librairie permettant de calculer ce noyau, tout comme même que Meta (Facebook) et bien d’autres.

Nul doute que l'ouverture de cette boîte noire qu'était le processus d'apprentissage machine pour les réseaux de neurones va encore faire progresser l'IA dans l'exécution de tâches complexes. De quoi alimenter les peurs d'une perte de contrôle par l'humain ? Plus que la crainte d'un dépassement de l'humain par l'IA, la façon dont on décide de l'utiliser est bien plus déterminante soutient le chercheur. L'enjeu majeur réside dans une utilisation éthique et responsable de l'IA : une plus grande transparence et une meilleure compréhension des modèles utilisés.

Ainsi Franck Gabriel, qui se définit comme un chercheur « jamais du milieu », s’intéresse aussi à la blockchain. Un système décentralisé de calcul qui pourrait s’avérer utile par exemple pour certifier la bonne utilisation de l’IA. « L’intelligence artificielle est un outil formidable pour nous aider à mieux comprendre le monde. Et c’est pourquoi j’ai envie de mieux cerner la propre représentation du monde de l’IA », conclut le chercheur.

Crédits photo de couverture : Éric le Roux / Direction de la communication Lyon 1

En savoir plus sur l'appel à projets Accueil

Référence : Jacot, A., Gabriel, F., & Hongler, C. (2018). Neural tangent kernel: Convergence and generalization in neural networks. Advances in neural information processing systems, 31.

fr

fr en

en